|

2024-04-17 18:10

조회: 1,691

추천: 0

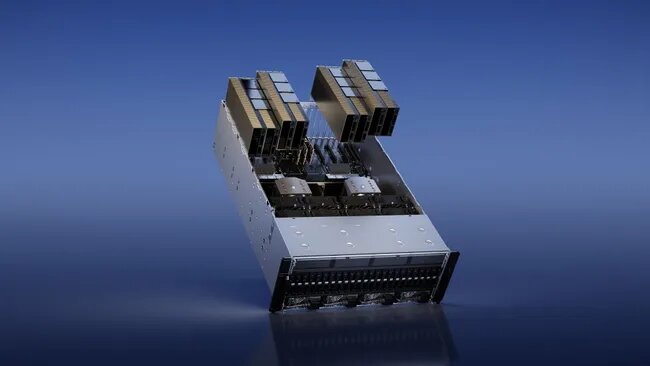

Nvidia의 H100 AI GPU 부족 현상은 리드 타임이 최대 4개월에서 8~12주로 단축됨에 따라 완화됩니다.기사 원문 - https://www.tomshardware.com/pc-components/gpus/nvidias-h100-ai-gpu-shortages-ease-as-lead-times-drop-from-up-to-four-months-to-8-12-weeks

Digitimes 에 따르면 Dell 대만 총책임자인 Terence Liao는 이전에 보고한 바와 같이 Nvidia H100 AI GPU의 배송 리드 타임이 지난 몇 달 동안 3~4개월에서 2~3개월(8-3개월)로 단축되었다고 보고했습니다 . 12주). 서버 ODM은 엔비디아의 H100 GPU 확보가 사실상 불가능했던 2023년에 비해 드디어 공급이 완화되고 있다고 밝혔다. 리드 타임이 줄어들었음에도 불구하고 Liao는 AI 지원 하드웨어에 대한 수요가 여전히 매우 높다고 말합니다. 특히, AI 서버의 가격이 엄청나게 높음에도 불구하고 AI 서버 구매가 기업의 범용 서버 구매를 대체하고 있습니다. 그러나 그는 조달 시간이 이에 대한 유일한 이유라고 믿습니다. 2~3개월의 배송 기간은 Nvidia의 H100 GPU에서 볼 수 있는 가장 짧은 리드 타임입니다. 불과 6개월 전만 해도 리드 타임은 11개월에 이르렀습니다 . 이는 대부분의 Nvidia 고객이 AI GPU 주문을 이행하기 위해 1년을 기다려야 한다는 것을 의미합니다. 2024년 초부터 리드타임이 크게 단축되었습니다. 첫째, 올해 초 3~4개월로 대폭 감소했습니다. 이제 리드 타임이 한 달 더 단축되었습니다. 이 속도라면 연말 또는 그 이전까지 리드 타임이 완전히 사라지는 것을 볼 수 있습니다. 이러한 동작은 잠재적으로 H100 GPU를 과잉 보유하고 미사용 재고의 높은 유지 관리 비용을 상쇄하기 위해 공급량 중 일부를 재판매하는 일부 회사의 연쇄 효과의 결과입니다. 또한 AWS는 클라우드를 통해 Nvidia H100 GPU를 보다 쉽게 임대할 수 있도록 했으며, 이는 H100 수요를 일부 완화하는 데도 도움이 됩니다. 공급 제약으로 어려움을 겪고 있는 유일한 Nvidia 고객은 자체 LLM을 개발하고 있는 OpenAI와 같은 대기업입니다. 이러한 회사에서는 LLM을 빠르고 효과적으로 교육하려면 수만, 수십만 개의 GPU가 필요합니다. 좋은 소식은 이것이 오랫동안 문제가 되어서는 안 된다는 것입니다. 지난 4개월 동안 그랬던 것처럼 리드 타임이 계속해서 기하급수적으로 짧아진다면 Nvidia의 최대 고객은 적어도 이론적으로는 필요한 모든 GPU를 손에 넣을 수 있어야 합니다.

EXP

97,774

(15%)

/ 102,001

|

인포메이션

명칭: 주식회사 인벤 | 등록번호: 경기 아51514 |

등록연월일: 2009. 12. 14 | 제호: 인벤(INVEN)

발행인: 박규상 | 편집인: 강민우 |

발행소: 경기도 성남시 분당구 구미로 9번길 3-4 한국빌딩 3층

발행연월일: 2004 11. 11 |

전화번호: 02 - 6393 - 7700 | E-mail: help@inven.co.kr

인벤의 콘텐츠 및 기사는 저작권법의 보호를 받으므로, 무단 전재, 복사, 배포 등을 금합니다.

Copyrightⓒ Inven. All rights reserved.

인터넷 신문 위원회 배너

2023.08.26 ~ 2026.08.25

인벤 온라인서비스 운영

(웹진, 커뮤니티, 마켓인벤)

▲

(주)인벤 사업자등록번호 : 120-86-74756

대표전화 : 02-6393-7700

FAX : 02-6393-7706

인벤의 콘텐츠 및 기사는 저작권법의 보호를 받으므로, 무단 전재·복사·배포 등을 금합니다.

Copyright © Inven Communications. All rights reserved.

대표전화 : 02-6393-7700

FAX : 02-6393-7706

인벤의 콘텐츠 및 기사는 저작권법의 보호를 받으므로, 무단 전재·복사·배포 등을 금합니다.

Copyright © Inven Communications. All rights reserved.

Bector

Bector